¿Por qué un juego de realidad virtual de Oculus pide un PC mucho más potente que un juego normal? 2016-01-07 12:31:10

La realidad virtual va a suponer una inversión de dinero importante, no solo en las Oculus Rift a las que ya ha puesto precio, sino también en el PC al que conectaremos estas gafas de RV para disfrutar de esas prometedoras experiencias.

Los responsables técnicos de Oculus ya explicaban hace meses cuáles serían los requisitos mínimos de esos PCs, pero tras conocer el precio de las Rift ahora nos preguntamos por qué la realidad virtual es tan exigente. ¿Por qué se necesitan muchos más recursos que con la mayoría de videojuegos tradicionales?

Simular un mundo virtual es todo un desafío técnicoHace tiempo que sabemos la inversión que nos permitiría disfrutar de la experiencia que ofrecen las Rift de Oculus podría rondar los 1.400 euros, pero ese coste puede variar notablemente si ya tenemos un PC con parte de los componentes necesarios para garantizar un buen comportamiento de la experiencia de realidad virtual.

EVE: Valkyrie es uno de esos juegos que prometen demostrarnos realmente qué nos ofrece la realidad virtual

EVE: Valkyrie es uno de esos juegos que prometen demostrarnos realmente qué nos ofrece la realidad virtual Los requisitos que marcaban los responsables de Oculus eran claros y sobre todo incidían en un apartado: el de la tarjeta gráfica. La potencia de este componente es clave fundamental para poder "mover" esos mundos virtuales con fluidez y con la suficiente precisión como para la sensación de presencia y de inmersión sea buena, pero como veíamos había otros factores relevantes:

| Tarjeta gráfica | Equivalente o superior a una NVIDIA GTX 970 o una AMD R9 290 |

| Procesador | Equivalente o superior a un Intel Core i5-4590 |

| Memoria RAM | 8 GB o superior |

| Puerto de salida | Salida de vídeo compatible con HDMI 1.3 |

| Puertos de entrada | 3 puertos USB 3.0 más un puerto USB 2.0 |

| Sistema Operativo | Windows 7 SP1 de 64 bit o posterior |

Como decimos, hay diversos requisitos técnicos que están orientados a un solo propósito: que la experiencia en esos mundos virtuales sea tan fluida como inmersiva, algo que hace necesario cumplir con unos mínimos en temas cruciales como la cantidad de información visual que se maneja por segundo, la monitorización y seguimiento de nuestros movimientos y sobre todo algo crítico: la latencia.

¿Por qué es necesaria tanta potencia?Lo cierto es que la realidad virtual hace que en primer lugar sea necesaria una tasa de fotogramas más alta de lo normal para tener esa sensación de que todo es natural en esa interacción virtual. Eso no solo ayuda a ofrecer esa calidad en la inmersión, sino también a reducir la célebre sensación de mareo que era muy común en las primeras ediciones para desarrolladores de las Rift y que se ha mejorado gradualmente con cada nueva iteración.

La distinción es clara con respecto a los videojuegos para ordenador, en los que normalmente lograr tasas de 30 fotogramas por segundo se considera suficiente para lograr una experiencia notable. Es cierto que aquí impera el cuanto más mejor y que las potentes gráficas dedicadas logran que incluso en juegos exigentes a altas resoluciones las tasas de FPS sean mucho mayores y superen incluso los 30 fotogramas por segundo, pero este tipo de configuraciones solo suelen ser aprovechadas por los gamers. Este es de hecho un tema que suele generar mucha polémica entre aquellos que defienden esa PC Master Race que existe y que otros -los que se sitúan más al lado de las consolas- creen que es un poco cansina.

En Oculus, no obstante, no han querido arriesgar y por ello piden gráficas potentes que garanticen una tasa de fotogramas elevada incluso con la resolución y frecuencias de refresco que se utilizan en las dos pantallas que nos sirven de singular pantalla televisiva y que nos trasladan a esos mundos virtuales.

De hecho la resolución y las frecuencias de refresco se han ido mejorando conforme han ido llegando las distintas ediciones preliminares de estas gafas de realidad virtual. En las DK1 la resolución total era de 1.280 x 800 píxeles a 60 Hz, con un campo de visión de 110° mientras que en las DK2 teníamos una resolución total de 1.920 x 1.080 píxeles a 75 Hz con un campo de visión de 100°.

En las Rift en su versión final para consumidores (lo que en foros de discusión como Reddit suelen llamar "CV1") la mejora es sensible y llegamos a los 2.160 × 1.200 píxeles en total (1.080 x 1.200 píxeles por pantalla) a 90 Hz. Parte de que esperaban con ansias ese dato en la versión final se sintieron decepcionados porque esperaban el salto a una resolución 1.440p, pero como señalaban varios usuarios en Reddit aquí Oculus no ha querido comprometerse y ha tomado una decisión que permitirá garantizar la fluidez sin perjudicar de forma notable la calidad de la imagen.

Precisamente esa resolución y frecuencia de refresco hace que el PC que conectemos a las Rift necesite procesar alrededor de 233 millones de píxeles por segundo, pero si además tenemos en cuenta que se da soporte a 10 bits de color tenemos como resultado que la transferencia de datos es ingente: 7 Gbps.

Si comparamos ese dato con un juego "convencional" nos encontramos con que en una resolución 1080p un juego a 60 Hz requiere el procesado de 124 millones de píxeles por segundo. En realidad las Rift tienen que hacer aún más cálculos y como explicaban sus técnicos la cifra asciende a los 400 millones de píxeles por segundo, algo que según esos ingenieros representa tres veces la potencia necesaria para ejecutar con fluidez esos juegos 1080p en el PC con los que estamos comparando esos requisitos hardware. Como explicaban allí,

La buena realidad virtual estéreo con seguimiento posicional lleva tu sistema de percepción directamente a un entorno de formas que un monitor plano no puede hacer. Como consecuencia de ello, las técnicas de renderizado y la calidad importan más que nunca, y cosas que son imperceptibles en un monitor tradicional de repente marcan la diferencia cuando se experientan en RV. Es por esta razón por la que la RV incrementa el valor del rendimiento de la GPU.

Ese dato condiciona otra de las especificaciones de las que nos hablaba Oculus en sus requisitos técnicos: el uso del estándar HDMI 1.3 es suficiente para garantizar que la transmisión de datos será fluida, ya que esta versión del estándar soporta hasta 10,2 Gbps si uno incluye además el "overhead" de la codificación de color de 10 bits (8,16 Gbps sin incluirla). El estándar HDMI 1.4 mantiene ese dato, aunque mejora la resolución máxima para dar soporte a resoluciones 4K DCI (4.096 x 2.160 a 24 Hz, no confundir con UHD, que baja a los 3.840 x 2.160 píxeles y que toda la industria ha utilizado indistintamente de forma incorrecta)

De hecho aquí lo que quieren en Oculus es, sencillamente, cubrirse las espaldas. Por eso nos piden PCs que produzcan tasas de fotogramas por segundo iguales o superiores a las tasas de refresco de las pantallas de las Rift. Si no se lograra eso, el resultado serían fotogramas perdidos que pueden no notarse demasiado en un PC conectado a un monitor para juegos convencionales, pero que en las gafas de RV sí se notan y mucho. De hecho, pueden ser causantes de esos mareos y vértigos que pueden convertir la experiencia en algo incómodo.

No queda claro si las Rift simplemente se negarán a funcionar si no detectan el hardware adecuado -tenéis esta herramienta oficial que verifica si vuestro PC está preparado- pero parece improbable que las gafas no hagan nada en ese caso. Lo que sí es probable es que la experiencia que tengamos con un hardware inferior al recomendado sea pobre y decepcionante, algo que lógicamente quieren evitar en Oculus.

La lucha contra la latenciaOtro de los apartados clave en los que la potencia gráfica desempeña un papel fundamental es en la reducción de la latencia, que representa básicamente el tiempo de respuesta del sistema a nuestras acciones y movimientos. La reducción de la latencia es una de las batallas que libran los fabricantes de tarjetas gráficas, y esos tiempos de respuesta se unen a otras latencias, las de red, que hacen que desde que nuestras acciones se realizan hasta que llegan al servidor del juego online -por centrarnos en este terreno- causen tiempos de respuesta altos y aparezcan los temidos lags que perjudican la experiencia en juego online.

Si esas latencias son importantes en el juego tradicional, lo son aún más en el terreno de la realidad virtual, y hay dos documentos técnicos muy especializados y profundos que pueden ayudaros a comprender mejor el problema. El primero es de Mike Abrash, que trabajó en Valve hasta ser fichado como Chief Scientist en Oculus y que explicaba ya a finales de 2012 cómo la latencia era algo crítico en este campo:

¿Cuánta latencia es demasiada? Mucho menos de lo que imaginarías. Para tener una referencia, los juegos generalmente tienen una latencia desde el movimiento del ratón a la actualización de la pantalla de 50 ms o superiores (algunas veces muy superiores), aunque he visto cifras que rondaban los 30 ms para juegos simples a nivel gráfico que tenían tearing (esto es, con vsync desactivado). En comparación, puedo deciros que según mi experiencia personal más de 20 ms es demasiado para la RV y especialmente para la realidad aumentada, pero las investigaciones indican que la barrera podría estar en los 15 ms e incluso en los 7 ms.

El artículo de Abrash es como decíamos un referente técnico, pero si hay otro protagonista clave en esa lucha contra la latencia en realidad virtual ese es nada menos que el legendario John Carmack, que hace tiempo que también fichó por Oculus pero que antes de hacerlo publicó su "Latency Mitigation Strategies" -curiosamente el blog original ha desaparecido, pero es posible rescatar el artículo aquí-.

En aquel documento Carmack reflexionaba sobre distintos tipos de técnicas para afrontar el problema de la latencia, y él también reconocía que si la latencia en las gafas de realidad virtual era de 50 ms tendríamos un sistema con una respuesta decente, pero "con retrasos sutiles". Aún así, explicaba "la verdadera reducción de la latencia debería ser perseguida de forma agresiva" y de hecho esa ha sido una de las metas en cada nueva evolución de las Oculus cuyo desarrollo ahora lidera este legendario programador.

No se conoce aún de forma clara la latencia a la que han logrado llegar con esa última versión final para usuarios de las Rift (en las DK1 estaba entre 50 y 60 ms, y en las DK2 se estimaban latencias entre 20 y 40 ms), pero cuando el dispositivo esté por fin disponible físicamente será un buen momento de evaluar este parámetro con dispositivos como el propio "Latency Tester" desarrollado por Oculus y que ahora, irónicamente, está agotado. Si queréis investigar aún más en este tema, en el blog de Oculus tenéis un artículo más para explorar este concepto.

NVIDIA y AMD en la carrera por la realidad virtualYa hemos dejado clara la relevancia de los procesadores gráficos a la hora de ofrecer la mejor experiencia posible en el terreno de la realidad virtual, pero aquí no solo Oculus está trabajando para mejorar la fluidez y calidad de la inmersión: son también las grandes del desarrollo de gráficas dedicadas las que están poniendo mucha leña en el asador.

NVIDIA lleva tiempo trabajando en este ámbito y de hecho recientemente quisieron reafirmar su apuesta total por este segmento. En una entrevista para VentureBeat Jason Paul, responsable del área de RV en NVIDIA, explicaba su visión de un mercado aún está en pañales. Aunque como siempre ocurre haya que coger sus comentarios con pinzas, había datos curiosos, y por ejemplo Paul revelaba que existen tan solo 13 millones de PCs (con gráficas NVIDIA dedicadas, se entiende) preparados para disfrutar de la experiencia que proponen en Oculus.

Los demás, afirman en NVIDIA, tendrán que ir actualizándose e ir adquiriendo tarjetas más potentes que evidentemente este directivo esperaba qeu fueran de su firma. Para defender sus argumentos explicaba el compromiso de NVIDIA con las tecnologías de realidad virtual y hablaba de GameWorks VR, un conjunto de librerías y APIs dirigidas a los desarrolladores y que permiten acceder a nuevas técnicas para lograr optimizar la experiencia de RV a través de esas gráficas.

Entre las posibilidades que ofrecen en NVIDIA están tanto la llamada VR SLI (es decir, aprovechar tu configuración SLI para esa experiencia de realidad virtual) como la prometedora tecnología Multi-Res Shading, dirigida a aprovechar la arquitectura Maxwell para sobre todo lograr más con menos: mayor eficiencia a través de un sistema de renderización de los mundos virtuales que combina la forma en la que trabaja el renderizado de los escenarios, personajes y objetos virtuales con el mundo de la óptica.

Como dicen en NVIDIA, en un renderizado de RV clásico se "dibujan" muchos pixeles que en realidad nunca llegan a la pantalla, y este sistema optimiza el uso de las GPUs para que estos procesadores trabajen donde se les necesita. Tenéis una explicación más profunda de la propuesta de NVIDIA en AnandTech.

Evidentemente en AMD no quieren quedarse atrás, y sus responsables también quieren defender su propuesta, llamada LiquidVR. En ella AMD trata de mejorar el soporte de la experiencia VR a través de tres pilares: el confort (reducir la latencia y mejorar el seguimiento del movimiento de nuestra cabeza), la compatibilidad para trabajar con todo tipo de gafas de RV, y los contenidos que puedan reproducirse y disfrutarse en entornos multi-GPU (CrossFire).

Hay varios componentes y tecnologías implicadas en todas esas mejoras, pero una de las más llamativas es la llamada Affinity Multi-GPU, que permite asignar una GPU por cada ojo cuando disponemos de un sistema CrossFire con dos tarjetas de AMD conectadas y trabajando de forma simultánea.

Este tipo de solución haría que cada tarjeta se encargase literalmente de cada ojo -o más bien, de cada pantalla- para lograr optimizar esa experiencia de usuario. Será interesante ver cómo se comporta en realidad, pero si queréis ir abriendo boca podéis explorar de nuevo el artículo técnico que realizaron en AnandTech y que habla más en detalle de todos esos conceptos.

ConclusionesAunque hay otros requisitos técnicos, y por ejemplo está el hecho de "obligarnos" a tener puertos USB 3.0 en nuestros ordenadores cuando los puertos USB 2.0 parecían perfectamente capaces de llevarnos a mundos virtuales en las Oculus DK1 y DK2. Aquí de nuevo lidiamos con ese intento de Oculus de tener margen de maniobra: el ancho de banda del estándar USB 3.0 permite que no haya potenciales cuellos de botella en este apartado a la hora de utilizar por ejemplo la cámara que sigue nuestros movimientos o incluso al del mando de control o los futuros Oculus Touch que aparecerán en la segunda mitad de 2016.

Así pues, nos encontramos con una filosofía en la que Oculus quiere asegurarse de que cuando disfrutemos de la realidad virtual, lo hagamos con las máximas garantías. Los responsables de esta firma han aclarado que esos requisitos mínimos no cambiarán con el tiempo y que por lo tanto el coste para cumplir con esas especificaciones se reducirá con la inexorable rebaja de los componentes con el tiempo, así que aunque en la actualidad acceder a este hardware tiene un coste elevado, hacerlo en los próximos meses -y años- será menos costoso.

Lo que parece evidente es que las comparaciones entre los videojuegos y contenidos de los que disfrutamos ahora mismo y los que nos propone el segmento de la realidad virtual son muy distintos. Estos últimos añaden una complejidad importante que seguramente sea cada vez más asumible por hardware más económico, pero hoy por hoy la conclusión es clara: para disfrutar de la realidad virtual necesitarás potencia, y mucha.

En Xataka | ¿Quién se está quedando fuera de la realidad virtual?

También te recomendamos

Guía para entender los formatos que usa tu disco duro y cuáles son sus ventajas

Nuevas gafas Gear VR: 99 dólares y compatible con los nuevos Galaxy de Samsung

Mark Zuckerberg se muestra impresionado con Toybox, la nueva demo para las Oculus Rift

-

La noticia ¿Por qué un juego de realidad virtual de Oculus pide un PC mucho más potente que un juego normal? fue publicada originalmente en Xataka por Javier Pastor .

La biblioteca pública de Nueva York digitaliza 187.000 imágenes, que podrás usar gratis 2016-01-07 03:30:49

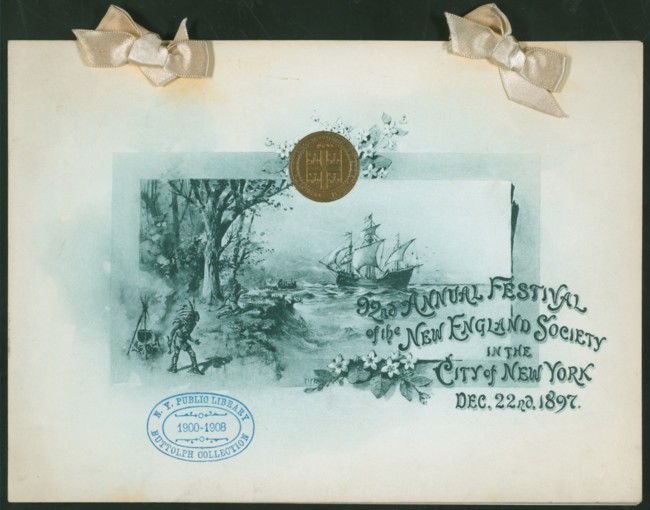

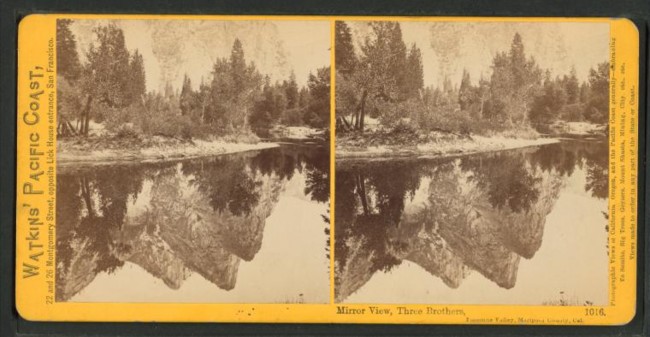

Si bien la búsqueda de imágenes libres (y visualmente atractivas) con las que ilustrar nuestros textos online puede convertirse en un auténtico suplicio y a pesar de que existen algunas opciones gratuitas ; ahora la biblioteca pública de Nueva York nos lo pone un poco más fácil. ¿La razón? Que acaba de darle un lavado de cara a su colección digital.

En concreto, el remozado catálogo incluye 187 mil nuevos recursos, entre los que encontramos fotografías, mapas, postales, grabados y otros; todos disponibles sin coste alguno a través de su página web para que cualquiera los use. Un proyecto que, por fin se ha hecho realidad y que trae de vuelta al presente, recuerdos de nuestra historia pasada.

Cuando el pasado regresa

De esta manera, la iniciativa, cuyos orígenes se remontan hasta cinco años atrás; ha dado lugar a un entramado de documentos en la red exhaustivamente organizado. Un material visual que, además de lo dicho, incluye partituras, pergaminos, dibujos antiguos, posters, ilustraciones y litografías; y que constituye el último empujoncito de la NYPL Labs, el equipo que se ha encargado de convertir este resultado en una realidad y en hacer de la biblioteca un lugar más accesible.

"Los cambios tienen el objetivo de facilitar el intercambio, la investigación y la reutilización por estudiosos, artistas, educadores, técnicos, editores y usuarios de Internet de todo tipo," ha apuntado la entidad. "Todas las colecciones de dominio público posteriormente digitalizadas se pondrán a disposición de la misma manera, y se unirán a un repositorio cada vez mayor de recursos públicos", ha recalcado.

Estos, asimismo, se encuentran estructurados de manera muy gráfica y resultan fáciles de encontrar. Entre los parámetros de clasificación hallamos la fecha, el género, el título, el color, la colección a la que pertenecen, etcétera. Además y según el ente público, los programadores también lo tendrán más sencillo para analizarlos de manera masiva. Respecto a su calidad, se encuentran disponibles desde 300px hasta en alta resolución.

Al margen de esta "liberación" (anteriormente, algunas de estas imágenes estaban disponibles, pero era necesario pagar para descargarlas), el órgano está alentando activamente a las personas y usuarios a hacer un uso creativo de su material en sus artículos y similares. Algo para lo que incluso ha llegado a ofrecer espacios de trabajo, financiación y hasta un servicio de promoción para aquellos que aporten ideas nuevas.

En definitiva una culminación memorable que ha nacido fruto de un arduo y laborioso trabajo y que constituye un excelente punto de partida que no pocas bibliotecas imitarán con el mismo propósito: el de hacer sus colecciones más accesibles para todo el mundo.

Vía | The Atlantic

En Genbeta | 31 webs para descargar fotografías gratis y sin conflictos sobre los derechos de autor

También te recomendamos

Google Plus Photos desaparecerá el 1 de agosto en beneficio del nuevo Google Photos

Los frameworks imprescindibles para desarrollar la web del futuro

Twitter podría incorporar filtros para imágenes antes de fin de año

-

La noticia La biblioteca pública de Nueva York digitaliza 187.000 imágenes, que podrás usar gratis fue publicada originalmente en Genbeta por Águeda A.Llorca .

El creador de Solitario nunca cobró un centavo 2016-01-05 17:24:29

Uno de los juegos más famosos de la historia, el mítico Solitario (Solitaire) de Windows, fue desarrollado por un practicante de Microsoft, Wes Cherry, y nunca ha recibido un pago por tal creación.

Un post en Reddit reveló este hecho y los usuarios comenzaron a buscar qué había sido del creador. Lo invocaron y se encontraron con que, en la actualidad, Wes se dedica a las manzanas. Al enterarnos de esto, lo primero que se nos pasa por la mente es que se trata de Apple, pero no, hablamos de la fruta, la que se come. Es dueño de Dragon's Head Cider, una empresa productora de sidra de manzana, cerca de Seattle.

En el '89, Cherry había jugado un juego similar a Solitario en Mac, pero quería una versión para él en Windows, así que durante su pasantía por Microsoft, escribió el código de fuente y logró desarrollar el juego.

Un programador de la empresa vio la creación y decidió incluirla en el sistema operativo. Y desde el '90, con su versión 3.0, Windows la integra en el paquete básico. La idea de la compañía era que los usuarios se acostumbraran a utilizar el mouse.

Claramente no le pagarían por lo ocurrido, pero lo abastecieron con un computador IBM XT para que arreglara los bugs durante el año universitario. Y a Wes le bastó con eso.

Opinar es gratis, como siempre. No olviden seguirnos y comentar en Facebook.

Overcast: La mejor aplicación de Podcasts para iOS 2016-01-05 11:11:06

Durante años, he sido fan de Pocket Casts. Y en Android, me sigue pareciendo la mejor opción. Pocket Casts se trata de una aplicación sumamente bien diseñada, con una interfaz que facilita el descubrimiento de nuevos podcasts, como su descarga y sincronización (sobre todo porque ofrece una interfaz web, además de las aplicaciones móviles).

Desde hace unos cuantos meses, sin embargo, me he mudado, al menos en iOS, a Overcast. Overcast es la app creada por Marco Arment, programador y creador de Instapaper (ahora le pertenece a otra empresa), además de ser un ávido podcaster (escuchen Accidental Tech Podcast, es genial). Inicialmente, Overcast funcionaba con un IAP – compra dentro de la aplicación – donde guardaba dos de sus características más importantes. Recientemente, sin embargo, ha cambiado de modelo, pasándose al de patronaje (sólo los que quieren, pueden pagar por la aplicación).

Qué hace a Overcast especial, y superior, en mi opinión, al resto de aplicaciones de podcasting? Overcast ofrece dos características que ninguna otra aplicación de Podcasting tiene:

- Smart Speed. Con Smart Speed, Overcast elimina los silencios en los podcasts en tiempo real. De esta manera, ahorramos tiempo y los podcasts se sienten más fluidos. Es una mejor opción a, por ejemplo, variar la velocidad de un podcast, pues no varía el pitch de las voces.

- Voice Boost. Para complementar al Smart Speed, el Voice Boost normaliza y aumenta el volumen de las voces de un podcast, de tal manera que todos los que participen en uno mantengan un mismo volumen. Esto es excelente para aquellos podcasts interesantes pero no tan prolijamente producidos, donde se nota una clara diferencia de volumen entre hosts.

Además de estas dos características, Overcast también ofrece excelentes recomendaciones de podcasts para escuchar – basándose en nuestros contactos de Twitter, y en una lista curada manualmente, y tenemos una gran cantidad de opciones para crear listas de reproducción.

Si recién se inician en el mundo del Podcasting y están buscando una buena app para descubrir shows, o escucharlos, Overcast en iOS es una excelente alternativa gratuita.

Usa Pocket Casts.

El Mejor reproductor de Podcasts, Pocket Casts, llega a la PC y Mac a través de un reproductor Web!

Buenas noticias, fans de podcasts! Pocket Casts, la mejor aplicación de Podcasts para Android y iOS, ha lanzado su versión Web, que nos permitirá escuchar nuestras subscripciones desde la PC. Debido a que Pocket Casts utiliza una cuenta para sincronizar podcasts entre dispositivos, esto significa que lo escuchemos en la PC quedará automáticamente sincronizado! Si aún no saben lo que son podcasts: Podcast se define como un programa de audio / video (usualmente de audio) que aparece con cierta periodicidad (dependiendo del programa, puede ser semanal, dos veces por semana, mensual, etc). La idea? Subscribirnos a

December 11, 2014 | Webs, Smartphones, noticias, Android, iPhone

El artículo Overcast: La mejor aplicación de Podcasts para iOS apareció primero en arturogoga.

arturogoga - tecnologia para todos. Smartphones, tablets, tips y tutoriales

cuarto país del mundo en uso de WhatsApp con una penetración del 70% según Ymedia y ¿Qué te hace más eficaz?

hackean la Agencia Espacial Europea sólo por diversión y herramientas y canales de YouTube para aprender a programar en VB .NET

Otras nueve webs y canales de YouTube para aprender VB NET desde cero hasta nivel experto y Puedes adoptar mascotas salvajes y seguir sus pasos por internet

La idea es ir girando las fichas y Las mejores opciones

Curso gratuito de AngularJS en KeepCoding y Nuevo curso online gratuito de HTML y CSS, en español

Consulte la Fuente de este Artículo

No hay comentarios:

Publicar un comentario